Künstliche Intelligenz ist längst kein Zukunftsthema mehr: Ob KI-Chatbots, Sprachassistenten oder generative KI‑Modelle – Unternehmen probieren und etablieren KI in ihren Kundenerlebnissen.

Bei Userlutions begleiten wir aktuell zwei typische Anwendungsszenarien:

- Kund:innen lassen ihre eigenen KI‑Chatbots testen, um zu verstehen, wie sie in echten Nutzerinteraktionen abschneiden.

- Kund:innen starten UX-Tests, in denen KI‑Assistenten (z. B. ChatGPT, Gemini) als Recherche‑ und Interaktionswerkzeuge verwendet werden – entweder zur Produktsuche, als Ideengeber oder als realitätsnaher „Sparringspartner“.

In diesem Artikel beleuchten wir beide Use Cases: Wir zeigen, worauf man im Testaufbau achten muss, welche Herausforderungen auftreten und welche Strategien sich bewährt haben – gestützt sowohl durch unsere Projekterfahrungen als auch durch aktuelle Forschung.

Warum sind UX-Tests von KI-Bots wichtig?

KI‑Komponenten bringen neue Dimensionen in die User-Experience: Nicht nur das Interface ist relevant, sondern auch das Modellverhalten, die Konsistenz, die Zuverlässigkeit und das Vertrauen, das Nutzer:innen der KI entgegenbringen.

Zwischen Novelty und Alltagsnutzen

Viele Testteilnehmende sind gegenüber KI grundsätzlich neugierig oder erwartungsfreudig – dieser Novelty-Effekt kann das Nutzerverhalten beeinflussen (z. B. mehr Nachsicht bei Fehlern), nutzt sich jedoch mit der Zeit ab.

Die explorative Phase ist für einen Großteil der Nutzer:innen vorbei. Man könnte sagen, sie haben sich daran gewöhnt, was KI leisten kann. Und je mehr KI erfolgreich zum Einsatz kommt, desto höher werden die Erwartungen der Nutzer:innen.

Die Frage, die sich Nutzer:innen heute stellen: Wie gut passt KI zu meinen Bedürfnissen?

Es reicht also nicht mehr, dass KI beeindruckende Dinge tun kann, sie muss Nutzer:innen auch einen wirklichen Mehrwert bieten.

Wir müssen daher verstehen, wie Nutzer:innen wirklich mit KI interagieren und wie reale User-Workflows wirklich aussehen. Und hier kommen User-Research und UX-Testing ins Spiel.

Praxisbeispiele und UX-Learnings über KI-Chatbots aus unseren Projekten

Innerhalb der letzten Monate haben wir einige Projekte durchgeführt, die sich mit UX-Tests von KI-Bots befasst haben. Natürlich können wir keine Details aus diesen Projekten verraten und haben die Erkenntnisse daher anonymisiert.

KI-Zusammenfassungen & Transparenz im redaktionellen Umfeld

Bei einem Projekt mit einem Verlag stand eine KI‑Zusammenfassungsfunktion im Fokus. Testpersonen waren relativ offen gegenüber der Technologie, besonders wenn sie bereits KI-Erfahrung hatten.

Ein zentraler Punkt: Vertrauen & Inhaltsseriosität wurden explizit über Fragen aus standardisierten Fragebögen abgefragt – etwa: „Würden Sie dieser Zusammenfassung trauen?“

Eine Herausforderung war, abzugrenzen, was redaktionell (menschlich) und was KI‑generiert ist, und zu entscheiden: Brauche ich überhaupt eine KI‑Zusammenfassung, wenn ohnehin schon eine gute Einleitung existiert?

KI-Chatbot in der Versicherungskommunikation

In einem anderen Projekt wurde ein Chatbot eingesetzt, über den Nutzer:innen Fragen zu ihren Versicherungsdokumenten stellen konnten (z. B. wenn sie gerade ein Anschreiben zu ihrem Vertrag erhalten haben).

Die Testpersonen konnten wählen, ob sie durch Spracheingabe oder schriftlich interagieren möchten. Überraschend war, dass sie fast ausschließlich Texte bevorzugten. Als Grund dafür gaben einige von ihnen an, dass sie sich schriftlich klarer und überlegter ausdrücken können. Auch dass dem Chatbot eine Stimme gegeben wurde, wurde von vielen Testpersonen als unnötig bezeichnet, zumal sie verzerrt und unnatürlich klang.

Dies illustriert: In vielen Kontexten ist Text als Medium geeigneter – besonders in Deutschland, wo die Hemmschwelle, mit einem digitalen System zu sprechen, höher sein kann als in Sprachkulturen wie den USA.

Der Bot hatte Zugriff auf das Kundenkonto, wodurch er sehr präzise Antworten geben konnte – was als großes Plus wahrgenommen wurde. Bedenken zur Datensicherheit wurden nicht geäußert. Wichtig also: Es muss einen echten Mehrwert geben, damit der Bot als hilfreich empfunden wird. Basiert er beispielsweise nur auf den FAQ, die auch für die User einfach auffindbar sind, reicht das nicht unbedingt aus.

Darüber hinaus gilt es, den Sweet Spot auf der Menschlichkeitsskala zu finden, also ob die Nutzer:innen das Gefühl vermittelt wird, mit einer echten Person oder mit einem Computer zu interagieren. Dieser Idealzustand kann je nach Use Case sehr unterschiedlich sein, weshalb es so wichtig ist, Chatbots mit echten Nutzer:innen zu testen.

Sensible Daten & Eskalationsprozesse

Wenn Themen wie Gesundheitsdaten oder mentale Gesundheit im Spiel waren, zeigte sich ein ausgeprägtes Misstrauen gegenüber KI-Systemen. Viele Nutzer:innen zogen echte menschliche Ansprechpartner vor – insbesondere wegen der Befürchtung, dass KI-Daten für Trainingszwecke verwendet werden könnten.

Hier ist Transparenz über Datenverwendung, Löschprozesse und Datenschutz essenziell.

No-Go: KI als Verkaufsmittel ohne Mehrwert

In einem Projekt sollte der KI-Bot sehr offensichtlich als Verkaufstreiber dienen und wurde von den Testpersonen als wenig hilfreich in Bezug auf ihre eigentlichen Probleme wahrgenommen. Die Angebote, die ihnen unterbreitetet wurden, bezeichneten sie als unpassend und störend.

Das zeigt: Wenn KI als „Verkaufsmittel“ eingesetzt wird, muss das sehr sorgfältig und mit Rücksicht auf die Nutzererwartung gemacht werden. Sonst können sie eher abschreckend wirken.

Wie schon in anderen Tests, zeigte sich auch hier, dass Bots als hilfreich wahrgenommen werden, wenn sie konkrete Schritte vorschlagen, wie User ihr Problem lösen können.

KI‑moderiertes UX‑Testing – Was kann es wirklich?

Auch im UX-Bereich gibt es natürlich immer mehr KI-Bots, die einem Arbeitsschritte abnehmen können. Wir haben daher auch eine Methodenevaluierung durchgeführt, in dem wir drei Testmethoden verglichen haben: moderiertes Testing durch Menschen, unmoderiertes Testing und von KI moderiertes Testing.

- Moderiertes Testing durch Menschen schnitt insgesamt in den meisten Dimensionen am besten ab.

- KI‑moderiertes Testing kam bei Nutzer:innen gut an (höherer Spaßfaktor, Novelty-Effekt), obwohl es in manchen Fällen technische Probleme gab.

- In einigen Szenarien erbrachte unmoderiertes Testing bessere Ergebnisse, z. B. in Effizienz oder Objektivität – besonders wenn UI und Interaktionslogik stabil waren.

Methoden & Vorgehensweisen: Was ist anders beim KI‑Testing?

Wer KI-Komponenten testen möchte, der muss einige zusätzliche Aspekte beachten im Vergleich zu klassischen Interface-Tests.

Realistischer Use-Case & mentale Modelle

Kund:innen müssen verstehen, wofür der Bot gut ist – und wofür nicht. Nutzer:innen müssen ein korrektes mentales Modell davon haben, was der Chatbot kann und was nicht.

Unklare Erwartungen führen schnell zu Frustration. Daher: Szenarien und Aufgaben möglichst realitätsnah gestalten.

Moderiert vs. unmoderiert

- Moderiertes Testing: Der Moderator kann bei Bedarf eingreifen, klären, nachfragen. Vorteil: Tiefere Einsichten, gezielte Steuerung. Nachteil: erhöhter Aufwand, möglicherweise Verzerrung durch Moderator‑Interaktion.

- Unmoderiertes Testing: Nutzer:innen machen unabhängig Aufgaben. Vorteil: realistische Interaktion, gutes Skalierungspotenzial. Nachteil: weniger Einsicht in Denkprozesse.

Aus Sicht unserer Berater:innen kann unmoderiertes Testing bei KI‑Chatbots sinnvoll sein, da bei moderierten Tests zwei Dialoglinien („Moderator“ vs. KI) parallel laufen müssen, was zu Störungen führen kann.

Qualitätskritierien & Nachbefragung

Nach dem Test sollten Nutzer:innen gezielt befragt werden: Wie hat ihnen das System gefallen? Was alles verständlich? Vertrauenswürdig? Was hat irritiert?

Um Themen wie Vertrauen und Inhaltsseriosität abzufragen, können standardisierte Fragebögen und Skalen wie der UEQ+ herangezogen werden.

Darüber hinaus können Metriken wie Fehlerquote, Fallback-Raten, Dialoglängen, Abbrüche, Antwortlatenz, konsistente Antworten herangezogen werden (ähnlich zu klassischen Chatbot‑Tests).

KI als „Testteilnehmer“: ChatGPT & Co. als Recherche- oder Interaktionspartner

Neben den Tests von eigens entwickelten KI-Chatbots besteht außerdem die Möglichkeit, externe KI-Systeme als Teil des Tests einzusetzen.

So wie wir unseren Kund:innen auch empfehlen, die Recherche in Suchmaschinen als Testeinstieg zu wählen, um herauszufinden, wie Nutzer:innen recherchieren und wie die Suchergebnisse wahrgenommen werden, ist es heutzutage genauso wichtig, einen Eindruck davon zu bekommen, wie die eigene Zielgruppe mit Chatbots wie ChatGPT interagiert.

Mögliche Use Cases und Fragestellungen

Hier eine kleine Sammlung an Ideen und Gedankenanstößen, zu welchen Themen Recherchen in Chatbots durchgeführt werden und wie diese in Verbindung mit Produkten oder Dienstleistungen gesetzt werden können. Natürlich sind die Möglichkeiten grenzenlos und wie ihr sie einsetzt kommt ganz auf das Angebot eures Unternehmens an.

- Produktrecherche: Wie würden potenzielle Kund:innen Informationen über unser Produkt oder unsere Dienstleistung mithilfe von ChatGPT oder Gemini suchen? Welche Begriffe verwenden sie? Welche Marken oder Alternativen werden ihnen vorgeschlagen – und was davon beeinflusst ihre Entscheidung?

- Urlaubsplanung: Wie plant jemand seine Reise mit Hilfe von KI? Welche Informationen erwartet er? Welche Services werden dabei empfohlen? Und an welcher Stelle könnte unser Angebot (z. B. Hotel, Reiseversicherung, Mobilität) Teil dieser Planung sein?

- Gesundheitsberatung: Welche Fragen stellen Nutzer:innen zu Gesundheitsthemen – und wie unterscheiden sich die Antworten je nach Formulierung? Werden bestimmte Begriffe als kritisch empfunden? Gibt es Unsicherheiten oder Widersprüche?

- Veranstaltungsplanung: Wie gehen Nutzer:innen vor, wenn sie eine Veranstaltung (z. B. Firmenfeier, Konferenz, private Feier) mithilfe von KI planen? Welche Anbieter werden ihnen genannt? Welche Kriterien sind relevant?

- Beratung zu Versicherungen oder rechtlichen Fragen: Wie formulieren Nutzer:innen Fragen zu komplexen oder vertrauenssensiblen Themen? Welche Antworten werden ihnen gegeben – und stimmen diese mit dem überein, was unser Produkt oder unsere Beratung tatsächlich leistet.

- Geschenkideen: Wie werden Produktkategorien oder konkrete Produkte vorgeschlagen? Was beeinflusst die Auswahl? Tauchen unsere Produkte auf – und wenn nicht, warum nicht?

- Nachhilfe: Welche Lernformate, Tools oder Anbieter empfiehlt eine KI auf Anfrage? Welche Erwartungen haben Nutzer:innen an digitale Bildungsangebote – und wo könnte unser Produkt (z. B. Lernplattform, App, Coachingangebot) positioniert werden?

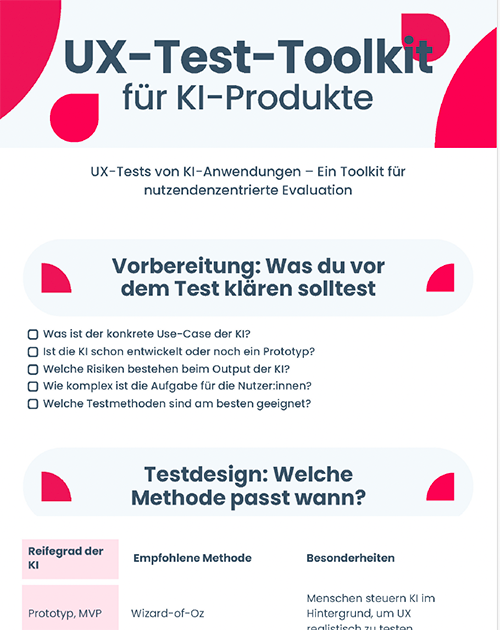

Hol dir unser UX-Test-Toolkit für KI-Produkte!

Du willst direkt loslegen? Unser Toolkit erleichtert dir den Einstieg, denn es stellt alle wichtigen Fragen und gibt dir Tipps, worauf du bei UX-Tests von KI-Chatbots achten musst.

UX-Tests von KI-Chatbots: Unsere Best Practices & Empfehlungen

Wenn du einen KI-Chatbot oder eine KI-gestützte Nutzerinteraktion testen möchtest, brauchst du nicht zwangsläufig ein fertiges Produkt – aber du brauchst ein klares Ziel. Denn UX-Testing bei KI funktioniert nur dann, wenn wir es an den richtigen Stellen ansetzen. Hier unsere wichtigsten Empfehlungen aus der Praxis:

1. Use Cases realistisch definieren

Stell sicher, dass die Aufgaben im Test dem tatsächlichen Nutzungskontext entsprechen. Nutzer:innen brauchen ein nachvollziehbares Szenario, das ihre Alltagslogik widerspiegelt – sonst bewerten sie nicht die KI, sondern das Testsetting.

2. Mentale Modelle einbeziehen

Frage im Test nicht nur im Anschluss: „Hat dir die Antwort weitergeholfen?“, sondern schon zu Beginn: „Was erwartest du?“ Viele UX-Probleme entstehen nicht durch falsche Antworten, sondern durch falsche Erwartungen. Das mentale Modell entscheidet, ob Vertrauen aufgebaut oder verloren wird.

3. Testmethode situationsabhängig auswählen

Moderiertes Testing liefert tiefe Einblicke, unmoderiertes Testing funktioniert gut bei konkreten Aufgaben oder klarer UI. Bei Chatbots kann unmoderiert besonders wertvoll sein – so entsteht ein natürlicherer Dialog mit der KI, ohne die „dritte Stimme“ der moderierenden Person.

4. Wizard-of-Oz als Übergangslösung

Wenn Teile der KI noch nicht stabil oder zuverlässig sind, kann man den Bot im Hintergrund „faken“ (Wizard‑of-Oz), sodass die Nutzer:innen denken, sie interagieren mit einer echten KI. Dadurch lässt sich die User-Experience evaluieren, auch wenn das Modell selbst noch nicht final ist.

5. Vertrauen gezielt abfragen

Gerade bei KI ist Vertrauen ein zentraler Faktor. Nutze offene Fragen oder Skalen, um zu verstehen, wann Nutzer:innen der KI glauben – und wann nicht. Themen wie Transparenz, Kontrolle und Datensicherheit gehören explizit dazu.

6. Fehler sind (auch) Erkenntnisse

Was die KI nicht kann, sagt oft mehr über den Use Case als das, was sie kann. Wenn Nutzer:innen abspringen, enttäuscht sind oder frustriert reagieren: genau hinschauen. Diese Momente zeigen, was verbessert werden muss.

7. Den KI-Sweet-Spot finden

Nicht jede KI muss wie ein Mensch wirken. Nicht jeder Bot braucht eine Stimme. Teste verschiedene Grade von „Menschlichkeit“, um zu sehen, was zu deinem Angebot – und zu den Erwartungen deiner Zielgruppe – passt. Auch andere Dimensionen wie Führung vs. Autonomität solltest du abtesten.

Fazit & Ausblick

KI ist da – und bleibt. Doch während technologische Sprünge gefeiert werden, bleibt oft unklar, wie gut diese Systeme im Alltag wirklich funktionieren. Genau hier setzen UX-Research und -Testing an: Wir helfen Unternehmen zu verstehen, was ihre Zielgruppe von KI erwartet – und was sie braucht.

Unsere Erfahrungen zeigen:

- Nutzer:innen sind bereit, mit KI zu interagieren – wenn sie den Mehrwert erkennen.

- Vertrauen, Klarheit und Kontrolle sind zentrale Kriterien für eine positive Nutzererfahrung.

- Die besten KI-Systeme überzeugen nicht durch das große „Wow“, sondern durch Verlässlichkeit im Kleinen.

- Der Testaufbau entscheidet maßgeblich darüber, wie nützlich die Ergebnisse wirklich sind.

- KI zu testen bedeutet nicht nur, technische Qualität zu prüfen – es bedeutet, die Bedürfnisse der Nutzer:innen zu verstehen. Nur so wird aus einer smarten Technologie ein echtes Produkt, das im Alltag überzeugt.

Wir bleiben gespannt auf die nächsten Entwicklungen – und begleiten gerne auch euer Projekt mit kritischem Blick, methodischer Klarheit und echtem Nutzerfokus.

Können wir euch bei der Entwicklung eures KI-Bots begleiten?

Deine Ansprechpartnerin

Birgit Bärnreuterh

Agenturleiterin

+49 30 544 870 24

(Mo bis Fr von 9 bis 18 Uhr)

Teilen

Diesen Artikel teilen